La UNED coordina el proyecto HAMiSoN con el objetivo de desarrollar tecnología que permita ayudar a luchar contra la desinformación. Se engloba dentro del programa europeo CHIST-ERA e involucra a la Universidad de Zurich para las Ciencias Aplicadas (Suiza), la Universidad de Tartu (Estonia) y la empresa Synapse Développement (Francia).

Por parte de la UNED participan tres profesores de la Escuela Técnica Superior de Ingeniería Informática. Anselmo Peñas Padilla, es doctor en Lenguajes y Sistemas Informáticos y especialista en diversas áreas, destacando en el campo del Procesamiento del Lenguaje Natural; Álvaro Rodrigo Yuste, es secretario académico del departamento de Lenguajes y Sistemas Informáticos y doctor en Inteligencia Artificial y Sistemas Informáticos; y Roberto Centeno Sánchez, profesor de Fundamentos de Informática y doctor en Informática. Anselmo Peñas nos habla del proyecto.

¿Qué características tiene una campaña de desinformación organizada? ¿Son más comunes que las orgánicas?

Anselmo Peñas (A.P.) En general, la difusión de desinformación mediante campañas organizadas es mucho menos voluminosa que la difusión oportunista de desinformación. Sin embargo, las campañas organizadas se crean de manera muy precisa para difundir algunas narrativas previamente determinadas, y lo consiguen de manera muy eficaz.

En general, este tipo de desinformación se corresponde a temáticas en las que suele haber algún agente con intereses específicos. Así, por ejemplo, la difusión de desinformación en torno a inmigración o feminismo no suele coordinarse, sino que distintos nodos en la red tienden a recogerlas y propagarlas. Sin embargo, las narrativas que tienen que ver con conflictos internacionales o el cambio climático suelen tener algún tipo de centro de pensamiento detrás.

De todos modos, a la hora de modelar el problema, no necesitamos que haya una correspondencia uno a uno entre los agentes que intervienen en la difusión de desinformación en el mundo real y en los modelos. En todos los casos, existe una intención, un efecto, agentes beneficiados y agentes perjudicados. Aunque no exista una coordinación física en el sentido de que distintas fuentes se hayan puesto previamente de acuerdo, si existe una coordinación de facto.

¿Este tipo de acciones son masivas o seleccionan a un perfil concreto de destinatarios para hacer llegar sus mensajes engañosos?

A.P. Nosotros no tenemos datos al respecto, pero evidentemente, si por alguna razón las fuentes de desinformación tuvieran acceso a la información de perfil de los usuarios de una red social, dirigirán a cada perfil el tipo de mensaje más efectivo. Esto es lo que pasó con Cambridge Analytics y Facebook en el caso del Brexit. Es conocido que existen una serie de empresas internacionales que ofrecen este tipo de servicios. Sin embargo, lo normal es que la mayoría de la desinformación trate de difundirse de manera general y masiva porque es mucho más barato.

¿Cómo ha nacido este proyecto?

A.P. El proyecto HAMiSoN nace gracias a una convocatoria del programa europeo CHIST-ERA dirigido al desarrollo de tecnologías digitales. En esta ocasión se seleccionaron cuatro proyectos para su financiación con el objetivo de desarrollar tecnología que permita ayudar a luchar contra la desinformación. Se trata de consorcios internacionales de al menos tres países diferentes y el objetivo es promover la colaboración transnacional. El proyecto que coordinamos desde la UNED involucra a la Universidad de Zurich para las Ciencias Aplicadas (Suiza), la Universidad de Tartu (Estonia) y la empresa Synapse Développement (Francia).

¿Cómo funciona el modelo propuesto en HAMiSoN para detectar la desinformación?

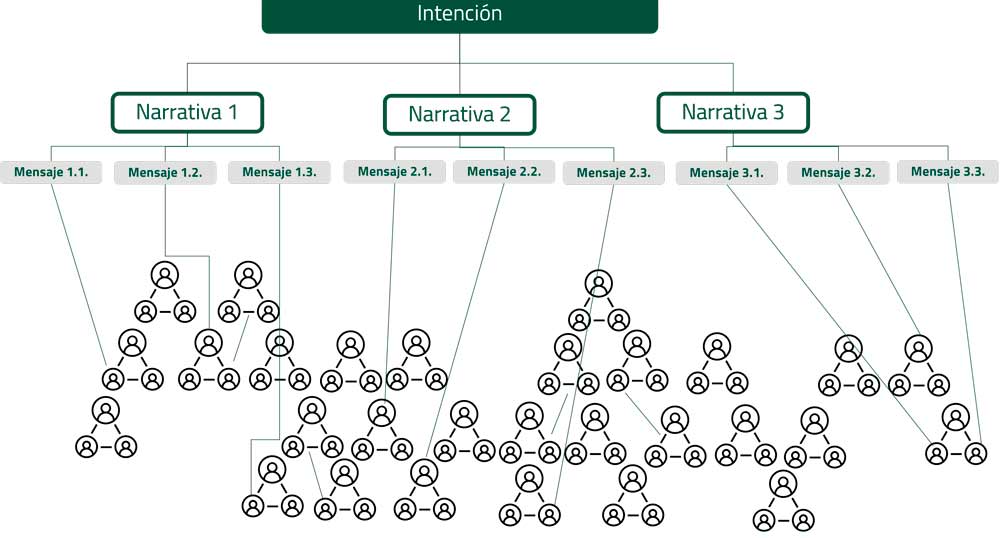

A.P. Asumimos que cualquier campaña de desinformación nace con una intencionalidad. Esa intencionalidad se manifiesta en la selección y propagación de determinadas narrativas que aparecen en determinados nodos de la red de manera más o menos coordinada (ya sea una coordinación intencionada u oportunista). Desde un punto de vista computacional, sólo observamos los mensajes que se difunden en la red, tanto su contenido como su propagación.

La idea es tratar de modelar el efecto, los agentes perjudicados por esa desinformación y el tipo de narrativa que se está utilizando. De esta manera, esperamos poder relacionar mensajes diferentes, de diferentes fuentes incluso con narrativas diferentes, pero con la misma intención. Esto nos permitiría agregar evidencias y tratar de detectar más mensajes que pasaron desapercibidos inicialmente.

¿Qué aporta HAMiSoN a las formas de detección usadas hasta ahora?

A.P. Por un lado, se combina tanto el texto como la forma en la que la información se difunde a través de las redes sociales, mientras que la mayoría de los enfoques anteriores se centraban en analizar solo el texto o solo la propagación en redes sociales. La idea es combinar ambos tipos de señales. Por otro lado, tratamos de agrupar acciones individuales dentro de campaña más generales, de modo que la información agregada pueda darnos más posibilidades de detectar más mensajes engañosos.

El proyecto acaba de arrancar ¿en qué actividad está inmerso?

A.P. El primer paso es construir los casos de uso. Nuestra tecnología se dirige tanto a los Fact Checkers como, por ejemplo, Maldita o Newtral, como a los analistas que hacen uso de sus servicios como, por ejemplo, los observadores internacionales de elecciones políticas. Para construir los casos de uso necesitamos hablar el mismo lenguaje que estos agentes sociales. Con este fin, nos reunimos con ellos, recogemos datos, los anotamos y con ellos buscamos maneras de entrenar los sistemas automáticos.

Entre los objetivos de HAMiSoN está el de desarrollar una herramienta de simulación para analizar posibles campañas coordinadas de desinformación. ¿Qué tipo de aprendizaje obtendría esta herramienta y cuáles son sus aplicaciones?

A.P. La idea de estos simuladores es que, una vez ajustados a los datos observados, nos permitan estudiar el efecto que podrían tener posibles acciones mitigadoras. Por ejemplo, sabemos que la mayoría del contagio se produce en las primeras horas tras la emisión de la desinformación, así que podríamos tratar de simular el escenario resultante si en esas primeras horas consiguiéramos una medida reductora del 10% (por poner un ejemplo) en determinados nodos de la red.

¿Estamos aún lejos de prevenir este tipo de acciones coordinadas?

A.P. Me temo que sí. Por una parte, la línea entre lo que es verdad, engañoso o mentira es muchas veces sutil. El simple hecho de descontextualizar una información ya tiene un efecto intencionado en el receptor.

Por otra parte, la definición del problema hoy por hoy es reactiva. Es decir, se espera a que se produzca la desinformación para tratar de desmentirla o mitigarla. Pero cuando se consigue, el mal ya está hecho. Una de las ideas de nuestro proyecto es que, en algunos escenarios, podemos predecir la desinformación que se va a propagar antes de que ocurra.

Por ejemplo, sabemos que en periodo electoral se tratará de desacreditar la manera en que se hace el recuento electrónico de votos y, por tanto, aparecerán noticias desacreditando a las empresas que lo realizan. En este caso, se pueden preparar campañas de información previa a las elecciones que ayuden a inmunizarnos contra este tipo de campañas de desinformación.

De todos modos, a medio plazo, la mejor opción sería ir introduciendo en las escuelas una especie de “educación vial” que tenga que ver con la información y la desinformación en las redes sociales. Es algo que ya se hace en los países nórdicos y que creo que se acogería bien por toda la ciudadanía. Todos estamos de acuerdo en que es un problema compartido.

El proyecto se desarrolla dentro de un trabajo conjunto coordinado por la UNED, con la participación de expertos de la Universidad de Ciencias Aplicadas de Suiza, El Instituto de Ciencias Computación de la Universidad de Tartu en Estonia y Synapse Développment, ¿qué perfiles tienen los miembros del proyecto?

A.P. Buscamos cierta complementariedad en el consorcio y, a la vez, un background común para poder entendernos. La UNED se centra en el uso de técnicas de Procesamiento del Lenguaje Natural para el análisis del contenido de los mensajes, y para tratar de modelar y clasificar los efectos y narrativas difundidas por los mensajes. También va a realizar simuladores basados en técnicas de multi-agentes.

La Universidad de Tartu se centra en el análisis de las redes sociales. La Universidad de Ciencias Aplicadas de Zurich aborda aspectos multimodales de la información como son el audio y el video. Finalmente, Synapse tiene el rol de que la tecnología desarrollada pueda transferirse a la sociedad.