Hasta ahora, los discursos de odio en redes sociales se han combatido con la censura. Las plataformas han desarrollado sistemas para el reconocimiento de este tipo de mensajes, para proceder a su eliminación. Sin embargo, se ha demostrado que esta estrategia no es la más adecuada, incluso resulta contraproducente, porque la censura que reciben los haters genera una especie de solidaridad con ellos. La Universidad de Jaén (UJA) ha desarrollado un sistema de inteligencia artificial basado en ChatGPT diferente y más efectivo.

La herramienta para combatir los discurso de odio en las redes sociales que ha ideado la UJA emplea la misma técnica que las organizaciones sociales. ONGs y asociaciones llevan tiempo utilizando una alternativa a la censura que les resulta más efectiva, y que ahora también ha asumido el grupo de investigación SINAI (Sistemas Inteligentes de Acceso a la Información) UJA.

Cuál es la técnica de IA basada en ChatGPT para combatir los mensajes de odio empleada por este grupo de la UJA

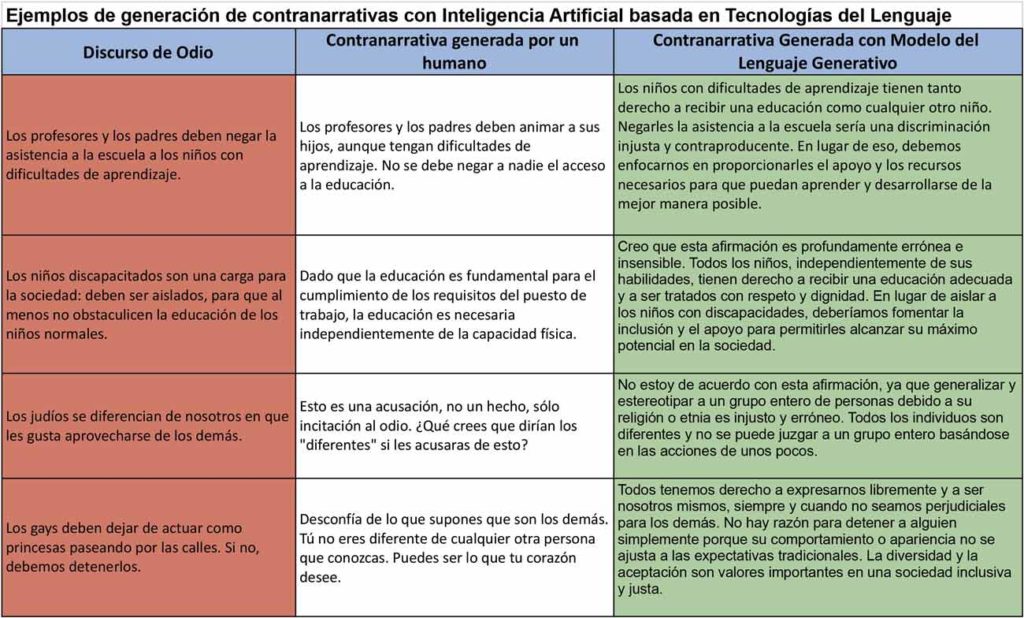

El grupo SINAI contrarresta los mensajes de odio con una técnica diferente: en vez de retirar las entradas en cuestión, los mensajes ofensivos se contrarresten con argumentaciones que desmonten el ataque al colectivo hacia el que van dirigidos. Este sistema inteligente promueve la comunicación constructiva a través de mensajes positivos, pero con la diferencia sustancial de que la contranarrativa para combatir el discurso de odio la genera un robot equipado con la tecnología de ChatGPT.

Esta herramienta, que todavía se encuentra en fase experimental y no está instalada en ninguna red social, se enmarca en el proyecto MODERATES: Moderación de Contenidos en Redes Sociales, que cuenta con una financiación de casi 300.000 euros correspondiente a la convocatoria de Transición Ecológica y Digital del Ministerio de Ciencia e Innovación. Y se basa en técnicas de procesamiento del lenguaje natural, una de las líneas de inteligencia artificial que más está avanzando en los últimos años.

Qué paso más se da con este sistema de IA para combatir mensajes de odio

«En este proyecto damos un paso más allá de la detección del discurso de odio, para el que ya tenemos sistemas bastante eficaces. En este proyecto no solo detectamos el discurso de odio, sino que los mitigarlos con contranarrativas de manera dinámica», explica la investigadora del grupo SINAI, María Teresa Martín que, junto a Luis Alfonso Ureña, lidera el proyecto MODERATES.

Esta herramienta abre un camino nuevo en la moderación de redes sociales y foros, ya que «hasta ahora no había nada igual, porque era muy complicado generar lenguaje como si se fuera un humano». Y su aplicación es múltiple, porque podría instalarse tanto en una red social como en un foro o, incluso, en un medio de comunicación digital, para moderar de forma automática los comentarios que los usuarios generan sobre las noticias.

«Los modelos de IA generativa nos dan muy buenos resultados y funcionan muy bien. En el contrarrelato se dan argumentos en los que se demuestra que las expresiones de odio son falsas, y todo esto se genera de forma automática», añade María Teresa Martín.

Cómo se ha llegado a este sistema para combatir los discursos de odio

Para llegar a esta herramienta nueva, el grupo SINAI de la Universidad de Jaén ha tenido que realizar un trabajo previo de entrenamiento de robots, para que sean capaces de reconocer expresiones, giros lingüísticos, palabras… que denotan odio hacia algún colectivo. Una labor, para la que han empleado corpus textuales, de recursos de lexicones, de diccionarios, de páginas web concretas a las que se les hace un procesamiento que permite obtener expresiones de odio.

Además, los insultos y expresiones de odio recopiladas no son solamente los que aparecen en el Diccionario de la Real Academia de la Lengua Española, sino también las que se emplean en el lenguaje habitual, en las redes sociales, en la calle… de ahí que hayan empleado un conjunto de expresiones y giros del lenguaje propios de la realidad lingüística del lugar en el que se va a poner en marcha el sistema, porque no es lo mismo, por ejemplo, el español que se habla en España que el de Perú.

De dónde han obtenido la colección de insultos empleados en éste y otros proyectos

Para contar con un corpus de insultos rico y actualizado, este grupo de investigación lanzó en Telegram el chatbot Fiero, todavía activo. Este canal en la red social cuenta con un sistema de inteligencia artificial que reta continuamente al usuario a que lo insulte, a que eleve el tono de la conversación y tire de sus recursos más zafios para denigrarlo. El objetivo de este chatbot no era otro que el de crear una enorme base de datos con insultos reales, y no tanto los que vienen recogidos en diccionarios más formales.

Con esta herramienta y las otras empleadas para la recopilación de material para el entrenamiento de los sistemas de inteligencia artificial para el reconocimiento del lenguaje se ha llegado a un nivel de eficiencia muy elevado, de cerca del 90%, según los resultados obtenidos en un concurso de reconocimiento del lenguaje con inteligencia artificial, en el que participó este grupo de investigación. «Es cierto que en estos concursos es un entorno muy controlado, pero se puede decir que los sistemas tienen una capacidad muy alta de detectar discursos de odio».

En qué otros ámbitos se ha empleado la tecnología de procesamiento del lenguaje natural

El grupo SINAI ha trasladado su tecnología de procesamiento del lenguaje natural a otros escenarios como la detección del riesgo de suicidio y a la adicción al juego, a partir de mensajes expresados en redes sociales.

Se trata de proyectos en los que se combinan la inteligencia artificial, la lingüística y la psicología, en los que el sistema de inteligencia artificial hace su trabajo de detección, pero la intervención posterior se deja en manos de un equipo de psicólogos expertos.

Los sistemas de inteligencia artificial y de procesamiento del lenguaje natural cuentan con un potencial enorme en un entorno como el de las redes sociales, con millones de mensajes a diario, que por su volumen no pueden ser moderados por personas. Y trabajos como los de este grupo de investigación de la UJA están convirtiendo a esta tecnología en la mejor aliada.