Por el momento, a Marte solamente se pueden enviar robots, pero no unos cualquiera, sino máquinas de última generación, que equipan los sistemas de control más avanzados que existen actualmente, que les permiten moverse en un entorno tan hostil como el planeta rojo y llevar a cabo experimentos complejos. Ahora, estos robots podrán mejorar todavía más, gracias a un algoritmo desarrollado en la Universidad de Costa Rica (UCR), que actúa como si fuera los ojos del vehículo.

El algoritmo ha sido desarrollado por el investigador de la Escuela de Ingeniería Eléctrica de la UCR, Geovanni Martínez Castillo, y se probará durante los próximos tres meses en las instalaciones de la NASA. Si los resultados son positivos, este sistema podría pasar a formar parte de los robots que recorrerán Marte en las próximas misiones espaciales.

De qué son capaces estos algoritmos para la nueva generación de robots de la NASA

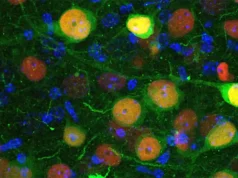

Los nuevos algoritmos permiten determinar el movimiento, la posición y la orientación tridimensional (3D) de robots mediante el procesamiento de dos señales multidimensionales, una señal de vídeo monocular en infrarrojo cercano (NIR) y una señal de profundidad por tiempo de vuelo (ToF); ambas proporcionadas por una cámara monocular NIR ToF rígidamente fijada a un costado del robot inclinada hacia el suelo. Estos algoritmos se conocen como algoritmos de odometría NIR ToF.

Los algoritmos de odometría son muy importantes para los robots de exploración en lugares donde no hay GPS, como en la Luna o Marte, ya que son capaces de proporcionar al robot información sobre su movimiento, posición y orientación 3D en todo momento, conocimientos que son utilizados por los robots para detectar si se están desviando de las trayectorias hacia los objetivos científicos, previamente recibidas desde la Tierra o planificadas por los propios robots en los lugares de exploración.

Si detectan desviaciones, los robots deben iniciar las acciones de control necesarias para modificar sus rumbos y volver y permanecer en las trayectorias previstas, de lo contrario podrían meterse en lugares de los que no podrían salir sin dañar sus estructuras, poniendo en peligro un día entero de exploración o incluso toda una misión.

Por qué se caracteriza este algoritmo

El algoritmo de odometría NIR ToF del investigador de la UCR determina la posición 3D del robot integrando el movimiento 3D del mismo a lo largo del tiempo, utilizando reglas de composición, donde el movimiento se estima minimizando el error fotométrico lineal medido en puntos de observación entre imágenes NIR consecutivas mediante la aplicación de un estimador iterativo de Máxima Verosimilitud, donde la posición 3D de los puntos de observación se obtiene de la profundidad ToF proporcionada por la cámara.

Hasta ahora el algoritmo ha demostrado ser bastante preciso, con errores absolutos de posición y orientación inferiores al 1 por ciento de la distancia y el ángulo recorridos, respectivamente; funciona en tiempo real y puede procesar hasta 50 fps a resolución VGA en un ordenador portátil convencional; además, como procesa imágenes NIR, es mucho menos sensible a los cambios locales de iluminación debido a sombras en movimiento y puede funcionar en la oscuridad.

Los resultados de las pruebas permitirán al Dr. Martínez demostrar “in situ” a los especialistas en robótica de NASA-JPL, la eficiencia de su algoritmo de odometría NIR ToF.